Memasuki 2026, kecerdasan buatan tidak lagi dinilai dari kecanggihannya, melainkan dari dampak nyatanya terhadap konsumen dan keadilan keputusan. Ketika adopsi AI melaju lebih cepat daripada regulasi, risiko fraud, kesalahan sistem, dan lemahnya perlindungan konsumen kian nyata. Industri keuangan dan multifinance dituntut berhenti berlindung di balik algoritma dan mulai menempatkan akuntabilitas manusia, transparansi, serta perlindungan publik sebagai fondasi utama penggunaan AI.

Fokus Utama:

■ Perkembangan AI melampaui kesiapan regulator, menciptakan celah pengawasan yang berpotensi merugikan konsumen melalui keputusan otomatis tanpa kejelasan tanggung jawab hukum.

■ AI mempercepat deteksi risiko, tetapi juga memperbesar kesalahan data, false positive fraud, dan manipulasi berbasis deepfake jika tata kelola dan kontrol manusia lemah.

■ Dalam banyak kebijakan AI, hak konsumen masih menjadi catatan kaki, sementara keputusan algoritmik langsung berdampak pada akses keuangan, reputasi, dan keadilan sosial.

Ledakan kecerdasan buatan memasuki 2026 membawa satu ironi besar: teknologi melaju eksponensial, sementara regulasi berjalan tertatih. Setelah bertahun-tahun dipromosikan sebagai mesin efisiensi dan pertumbuhan, AI kini menyingkap sisi gelapnya—bukan karena ia jahat, melainkan karena ia diadopsi lebih cepat daripada kemampuan negara dan industri mengawasinya. Di titik inilah risiko terbesar muncul: fraud, scam, salah keputusan, dan konsumen yang tak pernah benar-benar dilindungi.

Jika 2025 adalah tahun industri teknologi mengakui keterbatasan AI, maka 2026 akan menjadi tahun pengadilan publik. Bukan di ruang sidang, melainkan di rekening nasabah yang terkuras, keputusan kredit yang keliru, transaksi yang dimanipulasi, hingga trauma akibat kesalahan sistem yang tak pernah meminta maaf.

AI, Fraud, dan Ilusi Kecerdasan

Dalam sektor jasa keuangan, AI dipuja sebagai alat pendeteksi fraud, pencegah pencucian uang, dan mesin penilai risiko. Namun kenyataannya jauh lebih rumit. AI yang dilatih dari data buruk hanya akan mempercepat kesalahan lama dengan kecepatan mesin.

Kasus scam berbasis AI—mulai dari voice cloning untuk menipu nasabah, deepfake eksekutif perusahaan, hingga social engineering yang dipersonalisasi—melonjak tajam secara global sepanjang 2024–2025. Ironisnya, banyak lembaga keuangan justru mengandalkan AI generatif yang belum sepenuhnya dipahami risikonya untuk melawan kejahatan berbasis AI itu sendiri.

Di sinilah paradoks muncul: teknologi yang sama dipakai oleh penipu dan oleh institusi yang seharusnya melindungi konsumen. Perbedaannya bukan pada kecanggihan algoritma, melainkan pada tata kelola, pengawasan, dan tanggung jawab hukum ketika sistem gagal.

Regulator Selalu Datang Terlambat

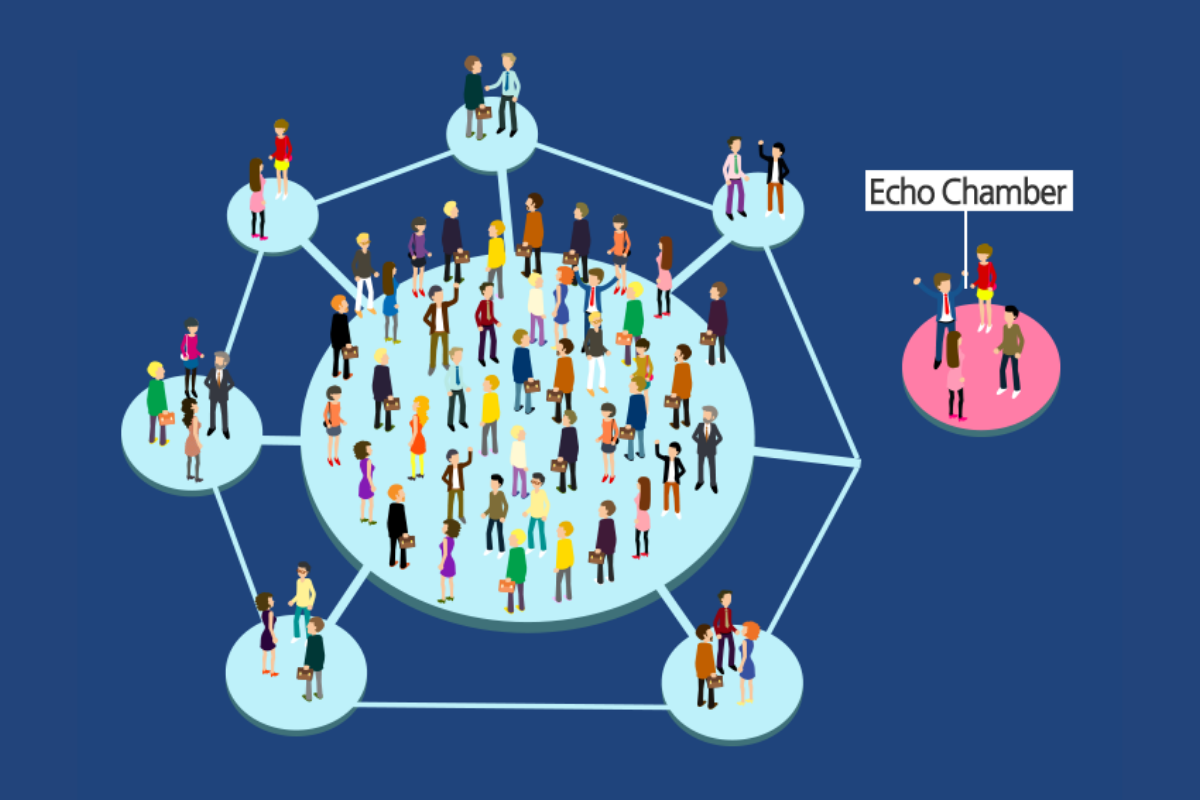

Regulator di banyak negara—termasuk di kawasan berkembang—masih sibuk mendefinisikan apa itu AI, ketika industri sudah menggunakannya untuk menentukan siapa layak kredit, siapa dicurigai fraud, bahkan siapa yang boleh mengakses layanan keuangan.

Pendekatan “sandbox” dan prinsip kehati-hatian memang penting, tetapi tidak cukup. Dalam praktiknya, pengawasan AI sering berhenti pada kepatuhan prosedural, bukan pada evaluasi dampak nyata bagi konsumen. Ketika AI salah, siapa yang bertanggung jawab? Vendor teknologi? Bank? Perusahaan multifinance? Atau konsumen yang dianggap “kurang literasi digital”?

Pertanyaan ini kerap menggantung tanpa jawaban tegas. Regulator terlalu sering terpukau oleh jargon inovasi dan efisiensi, tetapi abai pada satu fakta sederhana: AI bukan sekadar alat bantu, melainkan pengambil keputusan de facto. Dan setiap keputusan membawa konsekuensi hukum, sosial, dan moral.

Perlindungan Konsumen Masih Jadi Catatan Kaki

Dalam banyak kebijakan AI, perlindungan konsumen sering ditempatkan sebagai pelengkap—bukan fondasi. Padahal, di sektor keuangan dan multifinance, kesalahan kecil saja bisa berdampak besar: penolakan pembiayaan, bunga tidak adil, false positive fraud, hingga pemblokiran rekening tanpa penjelasan yang masuk akal.

AI sering kali tidak transparan. Nasabah tidak tahu mengapa pengajuannya ditolak, mengapa transaksinya dicurigai, atau mengapa akunnya dibekukan. Ketika bertanya, jawabannya klise: “sistem mendeteksi risiko”.

Masalahnya, sistem tidak bisa dimintai pertanggungjawaban. Nah, manusia bisa.

Tanpa kewajiban explainability yang kuat, AI berpotensi menjadi tameng sempurna bagi institusi untuk menghindari tanggung jawab. Ini bukan lagi isu teknologi, melainkan isu keadilan.

Industri Harus Berhenti Berlindung di Balik Algoritma

Perusahaan yang paling siap menghadapi 2026 bukanlah yang paling agresif mengadopsi AI, melainkan yang paling jujur mengakui risikonya. AI harus diperlakukan sebagai keputusan bisnis berisiko tinggi, setara dengan kebijakan kredit atau manajemen risiko—bukan sekadar proyek IT.

Pendekatan “human in the loop” tidak boleh menjadi slogan kosong. Harus ada manusia yang benar-benar diberi kewenangan untuk membatalkan keputusan AI, bukan sekadar menyetujui hasil mesin.

Saya sepakat dengan apa yang dikatakan Dima Gutzeit, pendiri dan CEO LeapXpert, perusahaan teknologi yang mengembangkan solusi komunikasi cerdas dan aman berbasis AI untuk kebutuhan perusahaan di seluruh dunia. Dia bilang, “AI hanya bernilai ketika data di bawahnya dapat dipercaya.” Jika tidak, AI bukan menciptakan kejelasan—melainkan memperbesar risiko secara sistemik.

2026: Tahun AI Diuji oleh Publik, Bukan Investor

Selama ini, AI dinilai oleh investor dan pasar modal. Ke depan, AI akan dinilai oleh publik—oleh nasabah yang dirugikan, oleh konsumen yang tak didengar, dan oleh masyarakat yang menuntut keadilan algoritmik. Jika regulator gagal mengejar, tekanan akan datang dari arah lain: litigasi, reputasi, dan krisis kepercayaan. Dan dalam industri keuangan, kepercayaan adalah mata uang paling mahal.

AI tidak perlu diperlambat. Tetapi ia harus ditundukkan pada satu prinsip sederhana: teknologi boleh cerdas, tetapi tanggung jawab tidak boleh otomatis. Jika tidak, 2026 bukan akan dikenang sebagai tahun pembuktian AI—melainkan tahun ketika kita sadar bahwa mesin sudah mengambil terlalu banyak keputusan tanpa cukup pengawasan.

*) Deddy H. Pakpahan, senior editor digitalbank.id.

Ilustrasi: vecteezy.com

Digionary:

● Artificial Intelligence (AI): Sistem komputasi yang meniru kemampuan manusia dalam menganalisis data, mengambil keputusan, dan memprediksi risiko.

● Explainability: Kemampuan sistem AI menjelaskan alasan di balik keputusan yang diambil secara transparan dan dapat dipahami manusia.

● False Positive: Kesalahan sistem yang menandai aktivitas normal sebagai berisiko atau mencurigakan.

● Human in the Loop: Model pengambilan keputusan AI yang tetap melibatkan manusia sebagai pengendali akhir.

● Tata Kelola AI: Kerangka kebijakan, pengawasan, dan tanggung jawab dalam pengembangan serta penggunaan AI secara etis dan aman.

#AI2026 #KecerdasanBuatan #RegulasiAI #PerlindunganKonsumen #FraudDigital #ScamAI #IndustriKeuangan #Multifinance #Fintech #GovernanceAI #HumanInTheLoop #KeamananDigital #EtikaAI #TransformasiDigital #RisikoTeknologi #KepercayaanPublik #Deepfake #LiterasiDigital #AIResponsibel #OpiniPublik